循环神经网络(Recurrent Neural Network, RNN):专为处理复杂序列数据而设计的高效神经网络模型

分类:杂谈

日期:

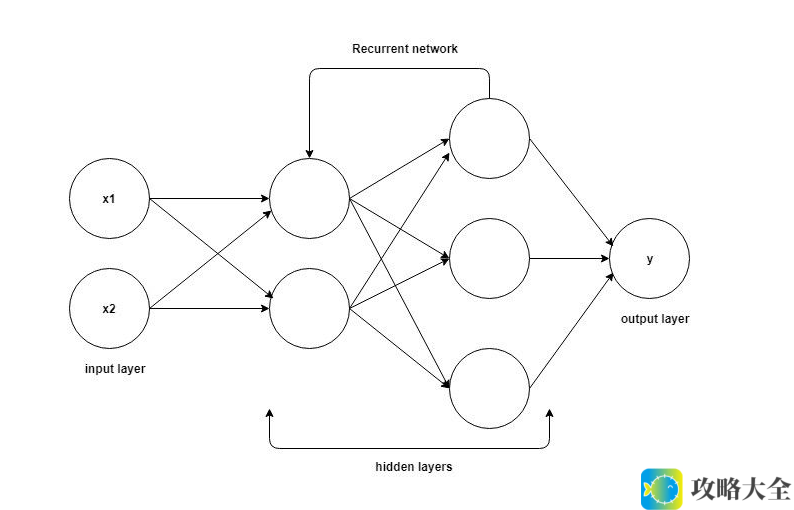

循环神经网络(RNN)是深度学习领域中一种专门用于处理序列数据的神经网络模型。与传统的前馈神经网络(FNN)不同,RNN能够在处理序列数据时,利用前一时刻的信息来影响当前时刻的输出,从而实现对序列数据中时间依赖性的建模。

一、RNN的基本构成

RNN的基本结构包括输入层、隐藏层和输出层,但与传统FNN不同的是,RNN的隐藏层之间存在着连接,使得隐藏层的状态可以传递到下一个时间步。这种结构使得RNN能够捕获序列数据中的时间依赖性。

- 输入层:接受当前时间步的输入数据。对于序列数据,输入层在每个时间步都会接收一个新的输入。

- 隐藏层:RNN的核心部分,包含一系列循环连接的神经元。这些神经元不仅接收当前时间步的输入数据,还接收上一个时间步隐藏层的状态作为输入,因此,隐藏层的状态是随时间变化的,并且包含了之前所有时间步的信息。

- 输出层:根据隐藏层的状态产生当前时间步的输出。对于序列数据的任务(如时间序列预测、文本生成等),输出层通常会在每个时间步都产生输出。

二、RNN的工作原理

RNN的工作原理可以概括为状态更新和输出计算两个过程。

- 状态更新:在每个时间步,RNN的隐藏层会根据当前时间步的输入数据和上一个时间步的状态来计算新的状态。这一过程是通过一个非线性变换来实现的,并且可以使用不同的权重矩阵来分别处理输入数据和上一个时间步的状态。

- 输出计算:在状态更新之后,RNN的输出层会根据隐藏层的状态来计算当前时间步的输出。输出计算通常也是通过一个非线性变换来实现的,并且使用一个额外的权重矩阵将隐藏层的状态映射到输出空间。

三、RNN的挑战与改进

尽管RNN在处理序列数据时具有强大的能力,但它也面临着一些挑战。其中最主要的是梯度消失和梯度爆炸问题,这会导致RNN在训练过程中难以捕获长距离的时间依赖性。

为了解决这个问题,研究者们提出了多种改进的RNN模型,如长短期记忆网络(LSTM)和门控循环单元(GRU)。这些模型通过引入门控机制和细胞状态等概念,使得RNN能够更好地处理长序列数据,并捕获其中的时间依赖性。

四、实例讲解:时间序列预测

假设我们有一个时间序列数据集,其中包含了一段时间内的股票价格。我们的目标是使用RNN来预测未来一段时间内的股票价格。

- 数据预处理:首先,我们需要对时间序列数据进行预处理,将其转换为RNN可以接受的输入格式。这通常包括将数据划分为训练集和测试集、对数据进行归一化或标准化等步骤。

- 构建RNN模型:接下来,我们构建一个RNN模型来处理这个时间序列数据。模型可以包括多个隐藏层,每个隐藏层都使用RNN单元(如LSTM或GRU)来捕获时间依赖性。

- 训练模型:使用训练集数据来训练RNN模型。在训练过程中,我们会不断调整模型的权重矩阵和偏置项,以最小化预测误差。

- 预测与评估:最后,我们使用测试集数据来评估RNN模型的性能。具体来说,我们可以将模型应用于测试集中的每个时间步,并计算预测的股票价格与实际股票价格之间的误差。通过比较不同模型的预测误差,我们可以选择性能最好的模型作为最终的预测模型。

通过这个实例,我们可以更加直观地理解RNN在处理序列数据时的基本流程和优势。RNN通过引入循环连接和状态更新机制,使得它能够捕获序列数据中的时间依赖性,并在各种序列处理任务中表现出色。

相关问题

1. RNN的主要挑战是什么?

2. LSTM和GRU是如何改进RNN模型的?

3. RNN如何应用于时间序列预测任务?